Существующие алгоритмы обучения с подкреплением, позволяющие роботам приобретать новые навыки путем проб и ошибок, не могут обойтись без вмешательства человека. Каждый раз, когда робот падает или выходит за границу тренировочной площадки, кто-то должен поднять его или вернуть на место.

Год назад группа разработчиков из команды Google Brain нашла способ обучать роботов в реальном мире. Обычно обучение с подкреплением ведется в виртуальных условиях: цифровой двойник машины бродит по цифровому пространству, пока не начнет уверенно ходить и ориентироваться. Затем его импортируют в тело машины. Этот метод позволяет избежать повреждений дорогостоящего оборудования, но требует относительного простой в моделировании среды — без случайно попавшего под колесо камешка или лежащего где не надо провода, рассказывает MIT Technology Review.

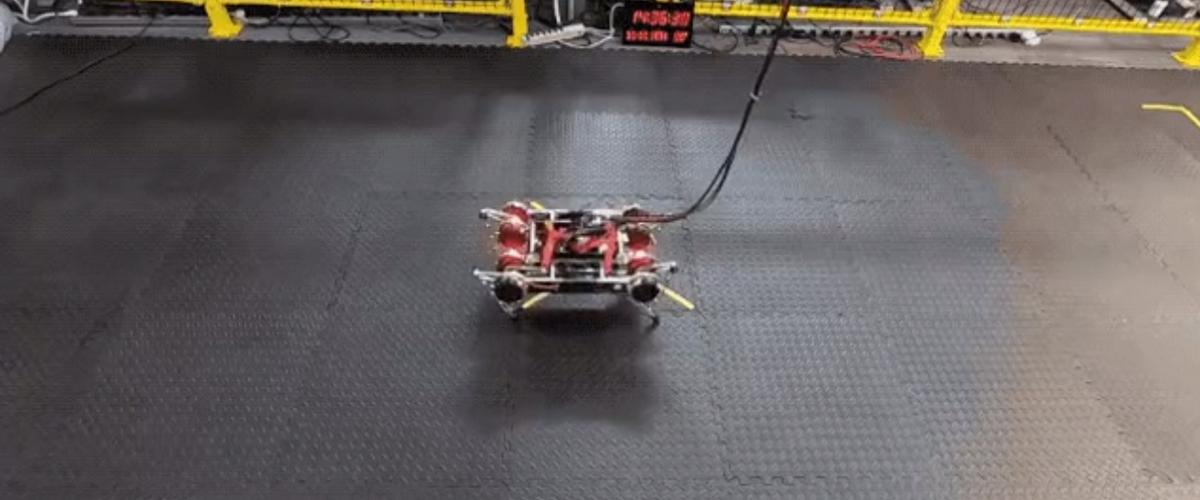

В данном случае ученые решили вести тренировку в реальных условиях. Они создали более эффективный алгоритм, который быстрее учится. В итоге весь процесс занял два часа. Робот смог быстро адаптироваться к однородной среде: ступеням, склонам и плоской поверхности с препятствиями.

Но человеку все еще приходилось нянчиться с роботом и вмешиваться в процесс сотни раз. Поэтому следующим этапом стало решение этой проблемы. Для начала ученые ограничили тренировочную площадку. Когда робот доходил до края, он должен был идти в обратную сторону и учиться двигаться задом наперед. Во-вторых, ученые ограничили движения машины, сделав ее достаточно осторожной, чтобы минимизировать ущерб от падения. А на случай, если она упадет, они добавили алгоритм, помогающий ей встать.

С помощью таких ухищрений робот автономно научился ходить по ровной поверхности, матрасу с памятью формы и половику с трещинами. В будущем такая система поможет машинам перемещаться по незнакомой местности без участия человека.

Самостоятельно научился ходить и сделанный японскими инженерами робот из сервоприводов и палок. Поначалу от учился в виртуальной среде, а потом смог двигаться и в реальности.