Некоторые учёные считают, что модели ИИ с открытом кодом равны свободному распространению оружия. Исследователи из Стэнфордского университета, Принстона и Массачусетского технологического института с ними решительно не согласны. Они разработали «Индекс прозрачности базовой модели«, чтобы оценить, насколько открыты 10 наиболее популярных моделей ИИ. Результаты показали, что большинство информации о том, как они устроены и работают, скрыто от общественности.

Прозрачность ИИ-моделей нужна не для тщеславия ученых. Она помогает использовать искусственный интеллект ответственно и эффективно, развивать его быстрее и качественнее, а также повышает безопасность. С помощью нее учёные и разработчики ускоряют прогресс в этой области, а пользователи понимают, как использовать модель и не получить от неё вред.

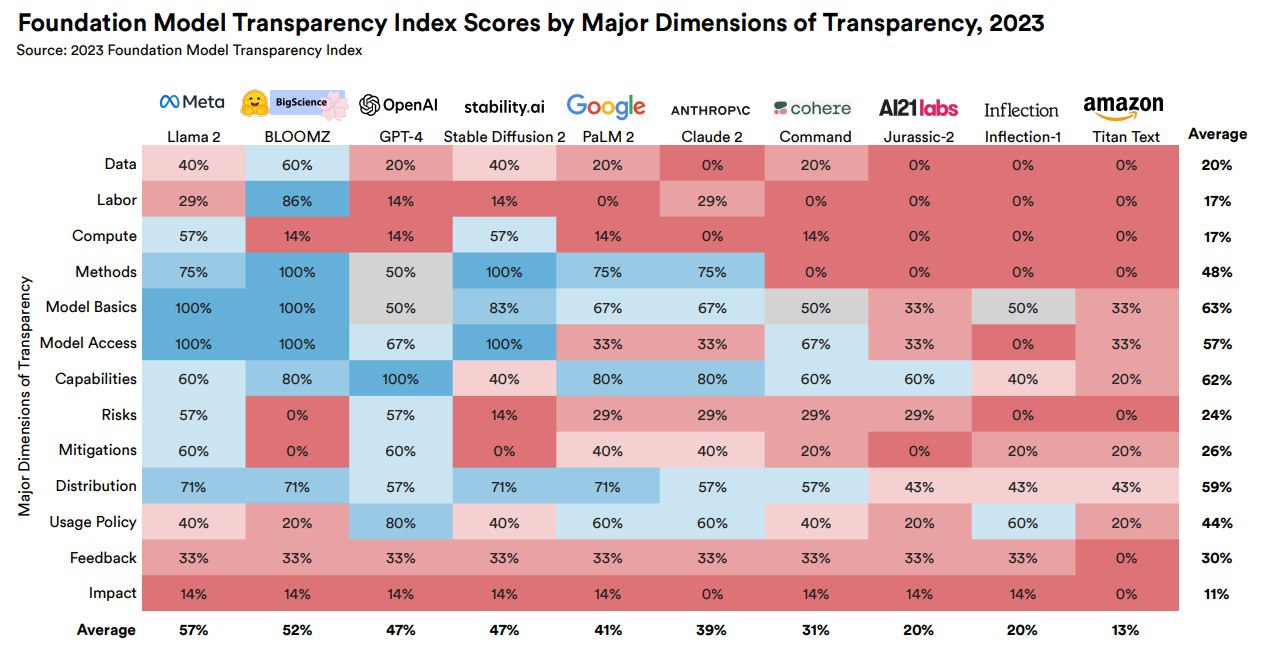

Индекс, оценивающий прозрачность, опирается на 100 детальных показателей. Они охватывают все аспекты модели, от затраченных на ее создание ресурсов (данные, на которых производилось обучение, труд, вычислительные мощности) до особенностей самой модели (возможности, риски, объём данных) и последующего использования (канал распространения, политика использования, география потребителей).

Результаты оказались удручающими: в среднем каждая модель ИИ набрала всего 37 баллов прозрачности из 100. Популярный ChatGPT открыт всего на 47%, а Titan Text от Amazon, лидер антирейтинга, готов показать миру всего 13% важной информации.

Стоит отметить, что исследователи обсуждали результаты теста с представителем каждой компании и давали им возможность аргументировано оспорить оценки. Если исследователи считали, что доводы разработчиков убедительны, они повышали оценку. Однако даже этот подход показал, что компании не спешат быть честными с пользователями.