Опасные изобретения

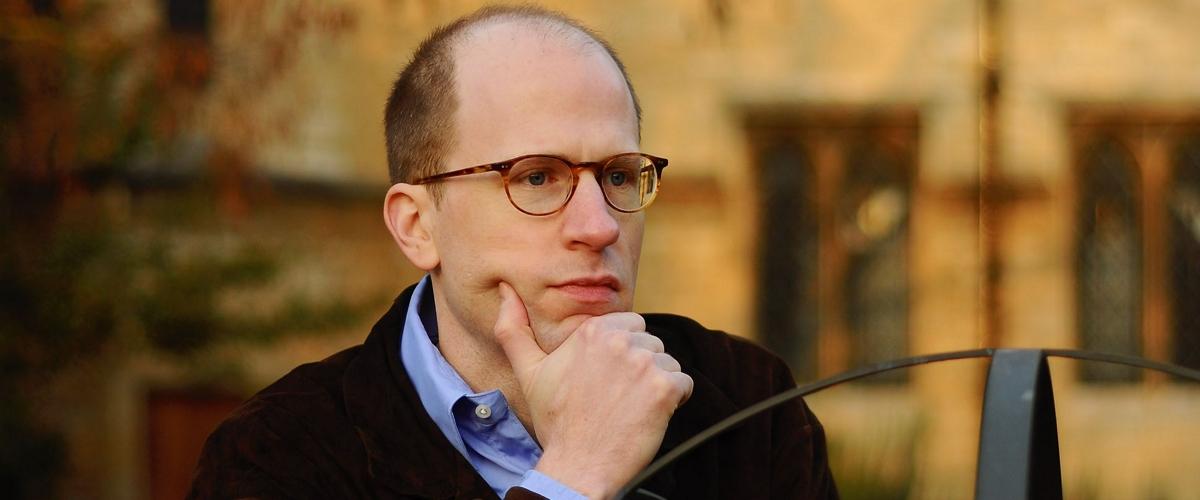

Профессор философии Оксфордского университета Ник Бостром получил известность благодаря своей гипотезе симулированного мира. Исследователь предположил, что человечество на каком-то этапе научилось создавать убедительные симуляции, словно в фильме «Матрица». И в одной из них мы живем сейчас.

Новая гипотеза Бострома уже не затрагивает вымышленные вселенные. В своей работе философ представляет концепцию уязвимого мира. Он уверен, что в какой-то момент технологический прогресс приведет к краху цивилизации.

В публикации Бостром проводит аналогию с ящиком Пандоры. Предположим, в нем хранятся три вида шаров. Белые символизируют технологии во благо человечества, серые — нейтральные разработки, а черные — открытия, несущие опасность. Каждое новое изобретение — это очередной объект, который достают из ящика. И пока людям попадались только белые и серые шары.

«Что, если нам все-таки попадется черный шар? У нас не будет возможности положить его обратно. Мы можем изобретать, но мы не умеем отменять изобретения», — цитирует Бострома Next Web.

По мнению философа, ядерное оружие пока нельзя отнести к категории черных шаров, поскольку технология устроена слишком сложно и доступна немногим. Но если человечество найдет быстрый и простой способ создавать атомные бомбы, то мир будет в опасности.

Бостром подчеркивает, что отследить деление на «черное» и «белое» не всегда просто. В какой-то момент разработка может перейти из одной категории в другую — в этот момент начнется период повышенной уязвимости.

В ряде случаев человечество может самостоятельно породить кризис. Например, если люди массово перестанут бороться с климатическими изменениями. Всеобщее бездействие приведет к глобальной катастрофе.

Эпоха ограничений

В этих условиях, пишет Бостром, многие государства заинтересованы в установлении стабильности. Философ упоминает четыре возможных сценария развития, каждый из которых связан с ограничениями.

В первом случае правительство может ограничить технологический прогресс. Во втором — сократить число лиц, которые могут быть заинтересованы в подрыве стабильного уклада. В третьем государство решит сделать ставку на предотвращение любой подозрительной активности. Четвертый сценарий предполагает введение мощной и единой системы контроля по всему миру.

Парадокс в том, что угроза глобальной катастрофы заставит многих смириться с подобными сценариями.

«Те, кто всегда с подозрением относился к государственной слежке, согласятся с принятыми мерами, чтобы избежать потрясений», — пишет Бостром. Многие предпочтут стать гражданами единого мирового государства, чтобы снизить возможные риски.

Ни один из сценариев исследователь не считает предпочтительным. Однако общество может расценить их иначе.

Хотя Бостром рассматривает будущее с позиции философа, он часто заступает на поле футурологии. Исследователь возглавляет Институт будущего человечества — центр при Оксфордском университете, в котором оценкой перспектив занимаются футурологи, инженеры и экономисты.

Ранее Бостром прогнозировал, что до конца столетия люди создадут машинный сверхинтеллект, а после этого вступят в фазу технологической зрелости. Только к этому времени появятся возможности строить симулированные миры и колонизировать другие планеты.