Сформулированный сооснователем Intel Гордоном Муром в 1965 году, закон Мура предсказывал, что количество транзисторов на компьютерных чипах будет удваиваться каждые 24 месяца, что, по сути, приведет к росту производительности этих чипов вдвое. Этот прогноз в основном оправдался, но в последние годы действие закона Мура замедлилось. Хуанг же утверждает, что развитие ИИ-чипов Nvidia происходит собственными темпами. «Мы можем разрабатывать одновременно архитектуру, чип, систему, библиотеки и алгоритмы. Это позволяет нам опережать закон Мура, поскольку инновации охватывают весь стек технологий», — сказал глава Nvidia.

Это громкое заявление прозвучало в то время, когда многие сомневаются в дальнейшем прогрессе ИИ. Хуанг, впрочем, не согласен с этим мнением. Он утверждает, что сейчас действуют три закона масштабирования ИИ: предварительное обучение (когда ИИ-модели учатся на больших объемах данных), последующее обучение (тонкая настройка ответов с помощью, например, отзывов людей) и вычисление во время выполнения (test-time compute), которое дает модели больше времени на «обдумывание» ответа.

По мнению Хуанга, подобно тому, как закон Мура способствовал удешевлению вычислений, развитие технологий логического вывода (inference) приведет к аналогичному снижению их стоимости за счет повышения производительности. Логический вывод — это процесс, в котором искусственный интеллект принимает решения или генерирует ответы, основываясь на имеющихся данных и правилах. Но необходимо учитывать, что Nvidia, став самой дорогой компанией благодаря успеху в сфере ИИ, заинтересована в продвижении этой идеи.

С переходом от обучения ИИ к логическому выводу позиции дорогих чипов Nvidia H100 пошатнулись. Высокая стоимость «рассуждений» ИИ ограничивает доступность таких передовых моделей, как o3 от OpenAI. Затраты OpenAI на одну задачу с использованием o3 для достижения человеческого уровня в тестах на интеллект составили около $20, что эквивалентно месячной подписке на ChatGPT Plus.

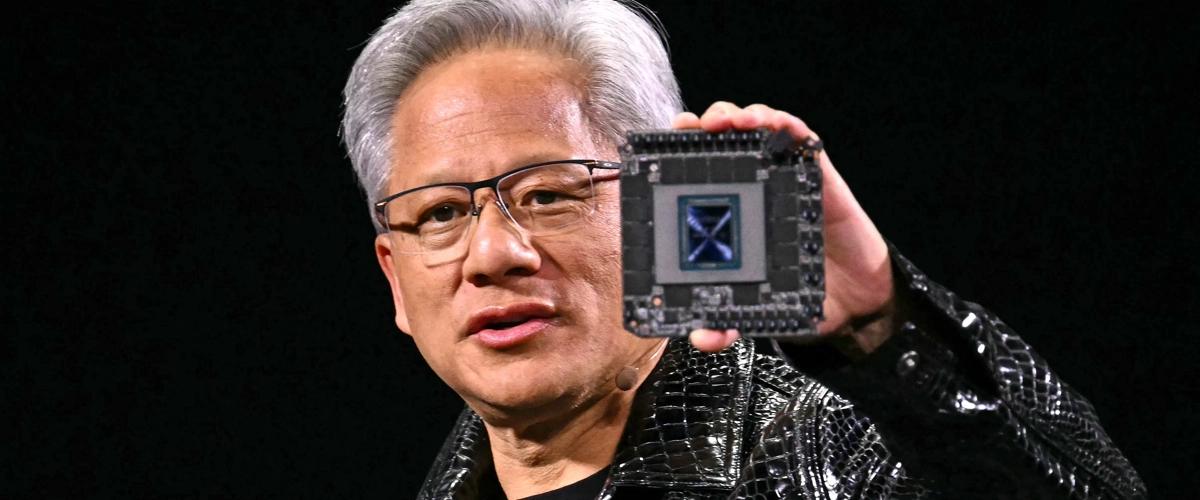

Хуанг во время выступления на CES представил новый суперчип Nvidia для центров обработки данных, GB200 NVL72. Этот чип обеспечивает прирост производительности в 30–40 раз по сравнению с предыдущим поколением (H100) при выполнении задач логического вывода ИИ. Хуанг уверен, что такой прорыв позволит снизить стоимость использования ресурсоемких моделей вроде o3 от OpenAI. Стратегия Хуанга заключается в создании все более производительных чипов, что, по его мнению, снизит цены в долгосрочной перспективе.

За последний год цены на ИИ-модели заметно упали, в том числе благодаря достижениям Nvidia. Хуанг считает, что эта тенденция сохранится и для «рассуждающих» моделей, хотя первые разработки OpenAI оказались довольно дорогими. Хуанг также заявил, что их нынешние ИИ-чипы в 1000 раз лучше, чем 10 лет назад. Это намного быстрее, чем предписывает закон Мура, и, по словам главы Nvidia, этот прогресс продолжится.