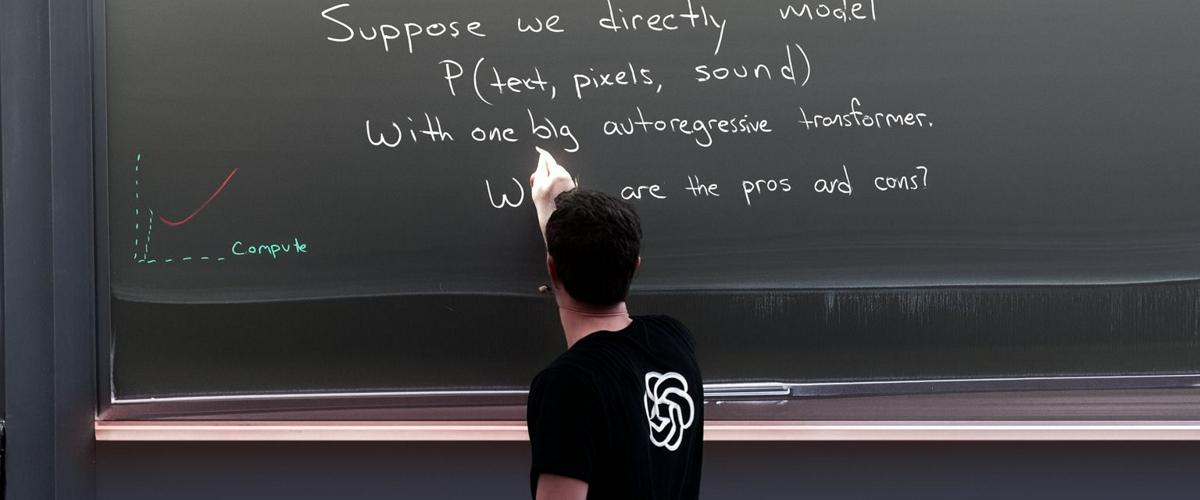

Изображение выглядит фотореалистично: человек в черной футболке с логотипом OpenAI пишет мелом на доске текст с надписью: «Перенос между модальностями. Предположим, мы напрямую моделируем P (текст, пиксели, звук) с помощью одного большого авторегрессионного преобразователя. Каковы плюсы и минусы?».

Новая модель GPT-4o, представленная 13 мая, является улучшенной версией предшествующей линейки моделей GPT-4 (GPT-4, GPT-4 Vision и GPT-4 Turbo). Новинка превосходит их по разным параметрам: скорость работы, стоимость обработки данных и способность сохранять больше информации из входных аудио- и видеопотоков.

Это стало возможным благодаря тому, что OpenAI применила другой подход. Предыдущие языковые модели GPT-4 объединяли работу нескольких отдельных моделей, преобразовывая другие форматы данных, такие как аудио и изображения, в текст и обратно. Новый GPT-4o изначально был обучен на мультимедийных токенах, что позволяет ему напрямую анализировать и интерпретировать визуальную и звуковую информацию, минуя этап текстового преобразования.

Судя по изображению, новый подход является заметным улучшением по сравнению с DALL-E 3, последней моделью генерации изображений OpenAI, представленной в сентябре 2023 года. Журналист VentureBeat запустил аналогичную подсказку через DALL-E 3 в ChatGPT. Созданное DALL-E 3 изображение значительно уступало GPT-4o по качеству, фотореалистичности и точности генерации текста.

Впрочем, пока возможности GPT-4o по генерации изображений недоступны широкой публике. Брокман в своей публикации написал: «Команда усердно работает над тем, чтобы предоставить их миру».