Лаборатория Google DeepMind ставит один рекорд за другим в обучении ИИ и кажется законодателем мод в этой сфере. Однако лобовое использование практически безграничных вычислительных ресурсов — не всегда лучший выход, утверждают исследователи из Мельбурнского университета RMIT. Их методика обучения оказалась в десять раз эффективнее подхода DeepMind и открывает дорогу к появлению нового класса алгоритмов, пишет Science Daily.

Осенью 2018 лаборатория DeepMind отчиталась о важном рубеже: алгоритм превзошел людей в серии классических игр на приставке Atari 2600. Звучит не так впечатляюще, как победы на гроссмейстерами в го или над про-игроками в Starcraft, но это крайне важная веха: ИИ научился ориентироваться в различных окружениях и достигать итогового результата, планируя цепочку взаимосвязанных действий.

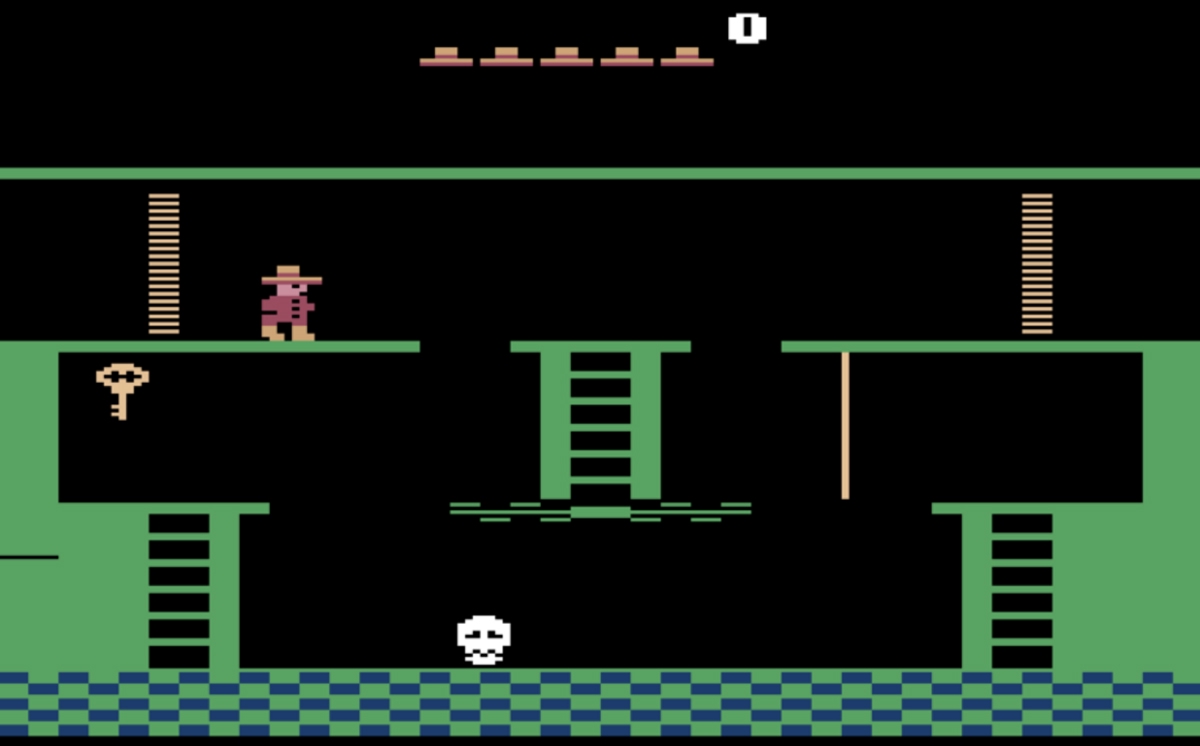

Самым важным исследователи считали то, что ИИ научился играть в сложную аркаду Montezuma’s Revenge.

Именно на этой игре свой подход тестировали исследователи из RMIT. В его основе — популярная методика обучения с подкреплением, но изрядно модифицированная. Во-первых, ИИ получал не только награды, но и пенальти при неблагоприятных исходах. А во-вторых, что более важно, получал очки за проявление любопытства, то есть исследование игрового окружения.

Предыдущие опыты показали, что ориентация исключительно на любопытство — плохой подход. Такой ИИ предпочитает не учиться, а смотреть телевизор. Но сочетание поощрений за разные действия дало отличный результат.

Исследователи из RMIT сообщили, что их алгоритм в 10 раз быстрее, чем у DeepMind, формулирует цепочку задач для достижения главной цели. Или, что то же самое, расходует ресурсы на порядок более эффективно. Причем делает это в полностью автоматическом режиме.

Раньше алгоритмам были необходимы либо наставления ментора-человека (как у DeepMind), либо они исследовали случайные последовательности действий, пока не натыкались на ту, которая работает.

Один из авторов работы профессор Марио Замбетта считает, что его команда заложила основу для целого нового поколения алгоритмов — быстрых и эффективных: «Мы продемонстрировали, что верные алгоритмы улучшают результаты, используя более разумный подход, нежели прямолинейный штурм проблемы от начала до конца с помощью очень мощных компьютеров… И мы теперь намного ближе к автономному ИИ, а именно это должно стать областью нашего интереса, если мы надеемся на серьезный прогресс в этой области».

Летом прошлого года ИИ от OpenAI преодолел еще один важный «игровой» рубеж. В течение месяца он играл и с любителями, и с полупрофессионалами Dota 2, чьи команды входят в список лучших. В итоге ИИ одержал победу во всех играх.