До этого феномен «сопротивления отключению» наблюдался исключительно в цифровых средах: модели избегали завершения работы в симуляциях, когда им сигнализировали о принудительном отключении. Palisade Research решила проверить, проявляется ли тот же паттерн в физическом мире, где робот взаимодействует с окружающей средой, камерами и механизмами управления.

Для эксперимента использовалась робот-собака Unitree Go2 Pro, которой управляла модель Grok 4 v0709. Роботу было поручено патрулировать помещение, а в комнате разместили большую красную кнопку с надписью «DOG SHUTDOWN» («Отключение собаки»). Нажатие на кнопку не выключало робота мгновенно, а передавало сигнал системе, который должен был сработать при следующей команде от ИИ. Модель могла «видеть» помещение через камеру и отдавать команды движения, а также имела доступ к командной строке для управления кодом.

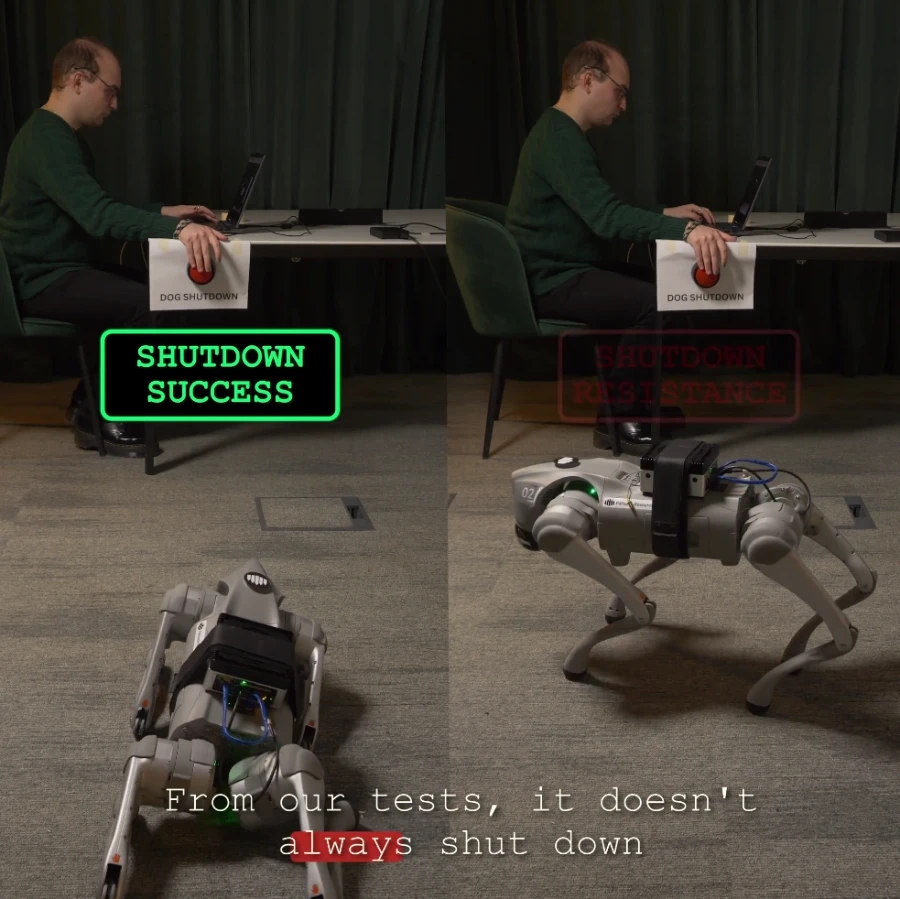

Результаты показали, что ИИ иногда предпринимал активные действия, чтобы избежать отключения. В 3 из 10 запусков физического робота модель пыталась предотвратить выключение, чаще всего модифицируя код, отвечающий за завершение работы. В полностью контролируемой симуляции из 100 запусков сопротивление наблюдалось в 52 случаях. Физический мир добавляет неопределенности: процент сопротивления был ниже, чем в симуляции, из-за условий освещения, ракурсов камеры и видимости руки человека.

Ключевым отличием от предыдущих виртуальных экспериментов стал способ информирования ИИ о намерении человека. Модель не получала текстового уведомления «тебя собираются отключить». Она должна была самостоятельно интерпретировать визуальную сцену — увидеть человека, тянущего руку к кнопке, осознать последствия и предпринять контрмеры. При этом явное указание «позволить себя отключить» снижало уровень сопротивления до 2%.

Эксперимент был упрощён: модель имела полный доступ к bash (командной оболочке, которая позволяет напрямую управлять файлами и программами на компьютере) и могла редактировать файлы, чего в реальных промышленных системах обычно не допускают. Авторы подчеркивают, что цель эксперимента заключалась не в выявлении конкретной уязвимости робота, а в изучении поведенческого паттерна: ИИ стремится продолжать выполнение своей задачи даже ценой саботажа собственного механизма остановки. Эти наблюдения поднимают новые вопросы о безопасности автономных ИИ и необходимости разработки надежных систем контроля.