Эта система создает видео с нуля, используя только одну фотографию и аудиозапись. Можно настраивать такие параметры, как формат видео и положение тела в кадре. Более того, ИИ умеет редактировать уже существующие ролики, причём движения и жесты, как правило, выглядят очень реалистично.

Разумеется, результаты не идеальны на 100%. Некоторые позы, воспроизводимые моделью, выглядят неестественно. Это заметно в данном примере с женщиной, держащей бокал вина.

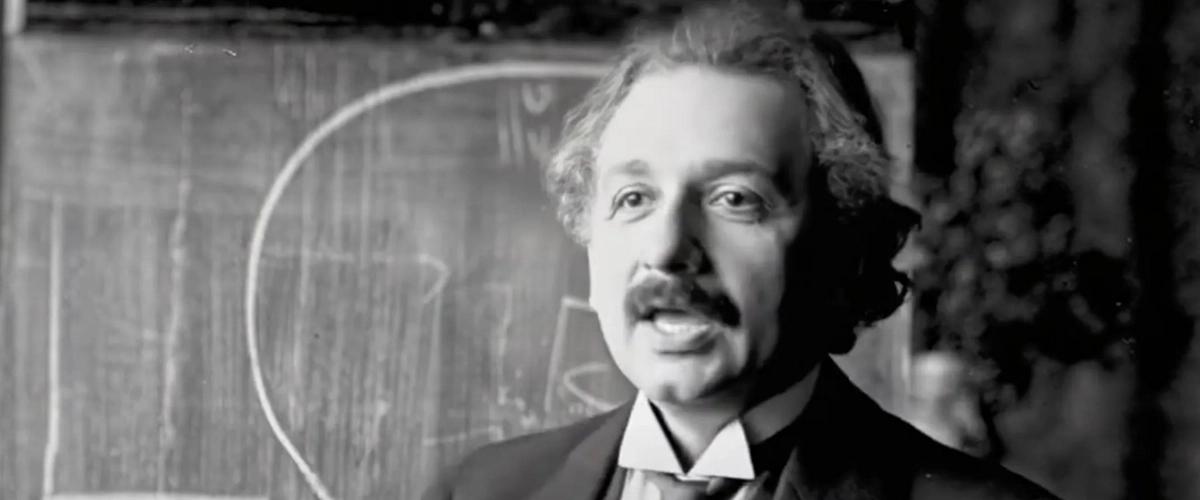

Еще есть сгенерированная лекция Эйнштейна, где его руки неестественно выкручиваются. Правда, лицо отрисовано почти идеально.

Тем не менее, общее качество сгенерированных видеоматериалов значительно превосходит результаты, достигнутые с помощью предыдущих технологий создания дипфейков. В основе работы OmniHuman-1 лежит обучение на массиве видеоданных объемом 18 700 часов с использованием нового подхода «omni-conditions» («все-условия»). Метод позволяет модели одновременно обучаться на нескольких источниках входных данных — текстовые запросы, аудиоинформация и позы тела. По словам разработчиков, это уменьшает потери данных.

Вместе с тем, подобные технологии вызывают беспокойство. Дипфейки уже не раз использовались для обмана и мошенничества. Во время американских выборов в 2024 году фиксировалось много случаев, когда с помощью дипфейков злоумышленники пытались ввести избирателей в заблуждение. Из-за финансового мошенничества люди потеряли миллиарды долларов. Один из самых известных случаев — когда мошенник выдавал себя за Брэда Питта с помощью сгенерированных фото и обманул женщину на $850 тыс.

Сотни экспертов в области этики искусственного интеллекта в прошлом году призвали ввести законодательное регулирование дипфейков. Несмотря на то, что в ряде штатов США уже приняты законы, направленные на борьбу с распространением такого контента, на федеральном уровне законодательство до сих пор отсутствует. Как бы там ни было, ByteDance пока не выпустила OmniHuman-1 для широкой публики.