Для большего правдоподобия, вдобавок к синхронизации движений губ, ученые из ИИ-центра Samsung в Кембридже и Имперского Колледжа Лондона добавили сокращения мимических мышц и моргание глаз, сообщает VentureBeat.

Исследователи надеются, что созданную ими модель можно будет применять для автоматического создания говорящих голов в анимированных фильмах, заполнения пробелов, когда видео прерывается из-за плохой связи или для дублированного перевода на другие языки. И для манипулятивных дипфейков, конечно.

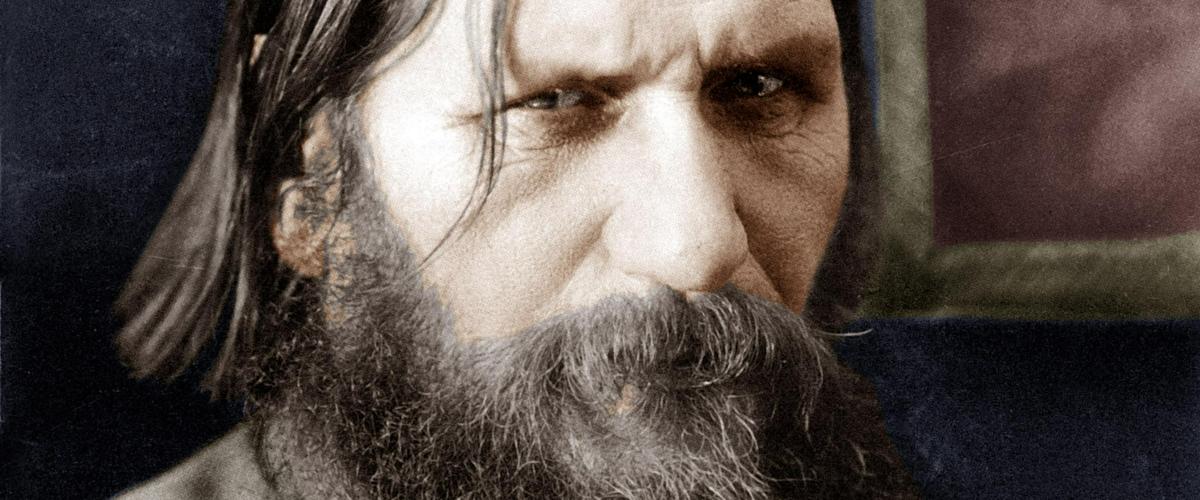

В примерах, выложенных на YouTube, Григорий Распутин распевает хит Бейонсе «Halo», покойные рэперы 2Pac и Biggie исполняют свои произведения, а Альберт Эйнштейн цитирует сам себя. Больше примеров и статью, описывающую работу модели, можно найти по ссылке.

Напомним, что месяц назад в исследовательском центре Samsung в Москве разработали ИИ, который анимирует двухмерные изображения без 3D-моделирования. А весной вышла социальная реклама с участием футболиста Дэвида Бекхэма, который убедительно рассказал на девяти языках о вреде малярии.